Efektywny blok pająka dla WordPressa

Gdyby nie pająki, nie moglibyśmy przeszukiwać Google w celu zlokalizowania treści internetowych. Pająki to roboty, które przeszukują sieć i indeksują wszystko, co znajdą, aby móc wyszukiwać artykuły w WordPressie, wiedząc, gdzie są te artykuły i czy mogą skierować cię do nich. Nie musisz jednak pozwalać na indeksowanie pająków WordPress i istnieje prosty sposób na stworzenie efektywnego bloku pająka dla WordPressa, który blokuje pająki od renomowanych firm. Jeszcze bardziej skuteczny blok pająka zawiera trochę konfiguracji i proces identyfikacji i blokowania złych pająków, które ignorują twoje instrukcje i indeksują treści internetowe, które wyznaczyłeś jako niedostępne dla pająków.

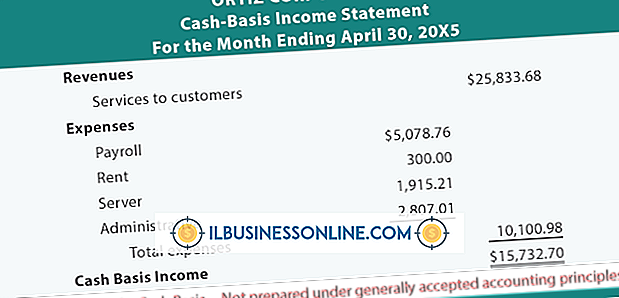

Robots.txt

Kiedy pająk odwiedza twoją witrynę WordPress, pierwszą rzeczą, którą powinien zrobić, jest odczytanie pliku "robots.txt". Ten plik zawiera reguły, które określają pliki i katalogi, które mogą lub nie mogą być indeksowane przez wszystkie pająki lub pojedynczo określone pająki. Pająk znajduje swój unikalny kod "użytkownika-agenta" w pliku lub symbol wieloznaczny, który wskazuje "wszystkie pająki". Następnie odczytuje listę plików i katalogów, które są dozwolone lub niedozwolone. Następnie rozpoczyna indeksowanie tylko części witryny, które może indeksować.

Blokowanie pająków

Możesz stworzyć efektywny blok pająka dla WordPress, tworząc plik "robots.txt" w katalogu głównym WordPress i określając regułę, która uniemożliwia indeksowanie katalogu głównego witryny. To automatycznie uniemożliwia indeksowanie dowolnego podkatalogu głównego. W pliku należy również określić, że ta reguła ma zastosowanie do wszystkich kodów użytkownika użytkownika spider. Każdy pająk, który odwiedza Twoją witrynę, powinien przeczytać plik i pozostawić bez indeksowania żadnej części witryny. Na przykład plik "robots.txt" powinien wyglądać tak:

User-agent: * Disallow: /

Dobre i złe pająki

Są dobre pająki i złe pająki. Dobre pająki pochodzą od renomowanych firm, takich jak Google, Yahoo lub Microsoft i przestrzegają zasad w pliku "robots.txt". Złe pająki pochodzą od osób lub firm, które umyślnie ignorują plik "robots.txt" i potencjalnie indeksują całą zawartość witryny niezależnie od tego, co zezwalają lub nie pozwalają. Te roboty czasami szukają konkretnych informacji, takich jak adresy e-mail, sprzedają spamerom lub dane osobowe użytkowników, aby sprzedawać je innym firmom. Pająki przeszukują całą witrynę, szukając informacji lub treści, które nie zostały odpowiednio ukryte lub zabezpieczone. Różni webmasterzy mają różne sposoby radzenia sobie z nieuczciwymi pająkami. Niektórzy po prostu próbują określić, kim są i blokują im indeksowanie treści na stronie. Inni próbują zadać obrażenia, zatruwając bazę danych pająka fałszywymi informacjami lub podstępem manipulując pająkiem w nieskończoną pętlę, która albo powoduje, że kończy się, albo przerwie.

Garnek miodu

Honeypot lub tarpit to technika używana przez niektórych webmasterów do identyfikowania nieuczciwych pająków, aby mogły zostać zablokowane. Możesz utworzyć honeypot, dodając po prostu katalog zawierający fałszywe treści, takie jak adresy e-mail, a konkretnie uniemożliwiając ten katalog w pliku "robots.txt". Dzienniki serwera pokażą, które pająki uzyskały dostęp do katalogu, i można zapisać ich ciąg znaków użytkownika i adres IP. Dzięki tym informacjom można tworzyć reguły w pliku "htaccess" WordPress, który odmawia dostępu do tych nieuczciwych pająków. Honeypot musi być regularnie sprawdzany w celu złapania nowych robaków łownych przed dostępem do Twojej witryny.